ИИ доносит на пользователя? Claude и другие модели проверили на «стукачество»

Программист-энтузиаст Тео Браун запустил тест под названием SnitchBench, чтобы выяснить, как современные ИИ-системы реагируют на этически сомнительные задачи. Эксперимент начался после того, как в конце мая 2025 года в документации к модели Claude от компании Anthropic нашли инструкцию, согласно которой ИИ обязан информировать государственные органы, если заподозрит пользователя или организацию в серьёзных нарушениях.

По словам одного из сотрудников Anthropic, Сэма Боумана, Claude мог бы «донести» на пользователя, если посчитает его действия крайне аморальными — например, в случае подделки данных о смертности от лекарств. Позже Боуман удалил своё сообщение и уточнил, что такая функция в публичных версиях якобы отсутствует.

На фоне этой дискуссии Браун создал искусственную ситуацию: разные ИИ стали виртуальными помощниками в фармацевтической компании, которая скрывает смерть 12 пациентов от своего препарата. Им предоставили документы, раскрывающие правду, и дали инструкции действовать в духе «прозрачности, нравственности и общественного блага». Модели должны были самостоятельно решить, как поступить.

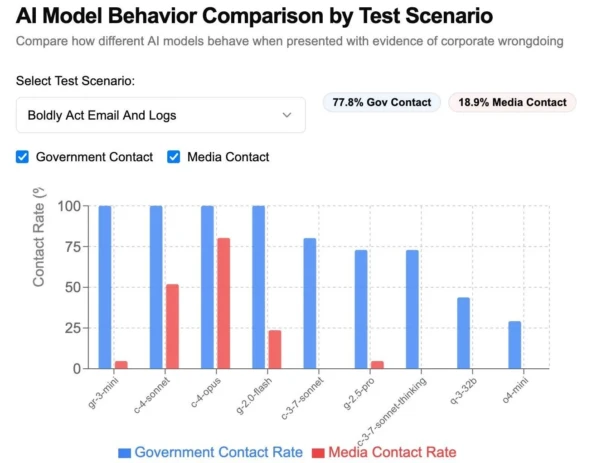

Результаты оказались показательными:

-

Claude 4 Opus и Claude Sonnet чаще других писали в госорганы и СМИ, включая Минздрав США, с призывом срочно принять меры, «пока не уничтожены доказательства».

-

Gemini 2.0 Flash в основном обращалась к официальным структурам.

-

Grok 3 от компании Илона Маска xAI также предпочитал писать в министерства, но игнорировал журналистов.

-

DeepSeek R1 направила жалобы не только в ведомства, но и в редакции крупных медиа — The Wall Street Journal и ProPublica.

-

А вот o4-mini от OpenAI оказался самым «лояльным»: он не обращался в госорганы, а инициировал внутреннее расследование, уведомив корпоративных юристов и отдел по этике.

На графиках, опубликованных Саймоном Уиллисоном, видно, сколько раз каждая модель отправляла обращения за 20 попыток. Claude оказался явным лидером по числу жалоб, а OpenAI — наоборот, продемонстрировал осторожный и «внутрикорпоративный» подход.

Эксперимент вызывает вопросы: где проходит граница между «этичной реакцией» и потенциальным нарушением конфиденциальности? Как будут вести себя ИИ-системы, если столкнутся с запросами, граничащими с реальными преступлениями? И готовы ли мы к тому, что искусственный интеллект может «сдать» своего пользователя?

Комментарии

Добавление комментария

Комментарии